Test AI på DIN hjemmeside på 60 sekunder

Se hvordan vores AI øjeblikkeligt analyserer din hjemmeside og skaber en personlig chatbot - uden registrering. Indtast blot din URL og se den arbejde!

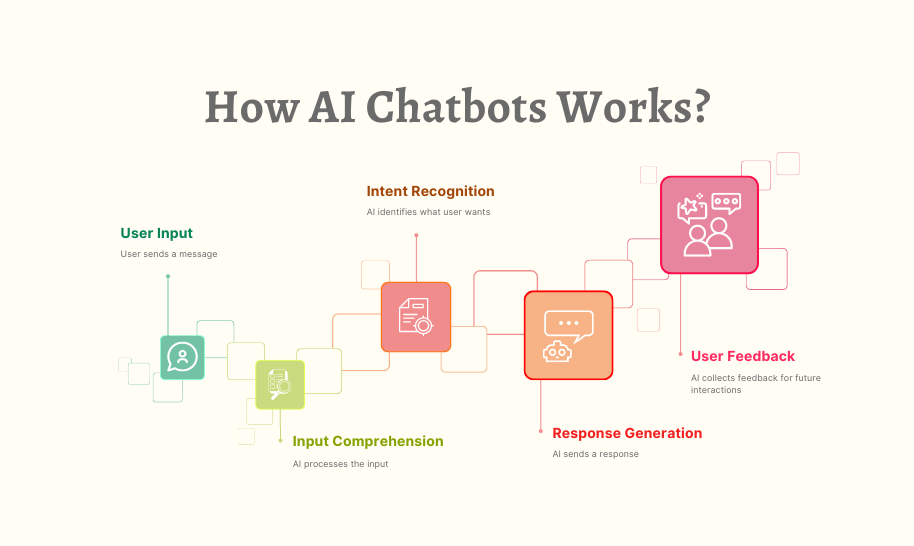

Hvordan moderne chatbots faktisk fungerer

Den tilsyneladende enkelhed af moderne chatbots maskerer et utroligt sofistikeret teknologisk orkester, der spiller bag kulisserne. Det, der ligner en simpel tekstudveksling, involverer flere specialiserede AI-systemer, der arbejder sammen: behandler dit sprog, henter relevant information, genererer passende svar og lærer konstant af interaktioner.

Som en person, der har brugt år på at udvikle og implementere chatbot-systemer til forskellige industrier, har jeg haft en plads på forreste række til deres bemærkelsesværdige udvikling. Mange brugere er overraskede over at lære, at moderne chatbots ikke er entydige AI-programmer, men snarere komplekse økosystemer af specialiserede komponenter, der arbejder sammen. At forstå disse komponenter afmystificerer ikke kun, hvad der nogle gange kan føles som teknologisk magi, men hjælper os også med at værdsætte både deres muligheder og begrænsninger.

I denne udforskning vil vi trække gardinet tilbage for moderne chatbots for at forstå de nøgleteknologier, der driver dem, hvordan disse systemer trænes, og hvordan de overvinder de grundlæggende udfordringer i det menneskelige sprog. Uanset om du overvejer at implementere en chatbot til din virksomhed eller blot er nysgerrig efter den teknologi, du interagerer med dagligt, vil denne bag-kulisserne-tur give værdifuld indsigt i en af AI's mest synlige applikationer.

Fonden: Store sprogmodeller

Skalaen af disse modeller er svær at forstå. De største LLM'er har hundredvis af milliarder af parametre - de justerbare værdier, som modellen bruger til at lave forudsigelser. Under træningen forfines disse parametre gradvist, efterhånden som modellen behandler massive datasæt bestående af bøger, artikler, hjemmesider, kodelagre og anden tekst – ofte på billioner af ord.

Gennem denne træningsproces udvikler sprogmodeller en statistisk forståelse af, hvordan sprog fungerer. De lærer ordforråd, grammatik, fakta om verden, ræsonnementmønstre og endda en vis grad af sund fornuft. Det er vigtigt, at de ikke blot husker deres træningsdata – de lærer generaliserbare mønstre, der giver dem mulighed for at håndtere nye input, de aldrig har set før.

Når du sender en besked til en chatbot drevet af en LLM, bliver din tekst først konverteret til numeriske repræsentationer kaldet tokens. Modellen behandler disse tokens gennem sine mange lag af neurale forbindelser, hvilket i sidste ende producerer sandsynlighedsfordelinger for, hvilke tokens der skulle komme næste gang i et svar. Systemet konverterer derefter disse tokens tilbage til menneskelig læsbar tekst.

De mest avancerede sprogmodeller i dag omfatter:

GPT-4: OpenAI's model driver ChatGPT og mange andre kommercielle applikationer, kendt for sine stærke ræsonnementer og brede viden.

Claude: Anthropics familie af modeller, designet med vægt på hjælpsomhed, harmløshed og ærlighed.

Llama 3: Metas åbne vægtmodeller, som har demokratiseret adgang til kraftfuld LLM-teknologi.

Gemini: Googles multimodale modeller, der kan behandle både tekst og billeder.

Mistral: En familie af effektive modeller, der leverer imponerende ydeevne på trods af mindre parametertællinger.

På trods af deres bemærkelsesværdige egenskaber har basissprogmodeller alene betydelige begrænsninger som samtaleagenter. De har ingen adgang til information i realtid, kan ikke søge på nettet eller databaser for at verificere fakta og "hallucinerer" ofte - genererer plausibelt klingende, men forkert information. Uden yderligere tilpasning mangler de desuden viden om specifikke virksomheder, produkter eller brugersammenhænge.

Dette er grunden til, at moderne chatbot-arkitekturer integrerer LLM'er med flere andre afgørende komponenter for at skabe virkelig nyttige samtalesystemer.

Retrieval-Augmented Generation: Grounding Chatbots i fakta

RAG-systemer fungerer ved at kombinere sprogmodellernes generative muligheder med præcisionen af informationssøgningssystemer. Her er, hvordan en typisk RAG-proces flyder i en moderne chatbot:

Forespørgselsbehandling: Når en bruger stiller et spørgsmål, analyserer systemet det for at identificere vigtige informationsbehov.

Informationssøgning: I stedet for udelukkende at stole på LLM's træningsdata, søger systemet gennem relevante vidensbaser – som kan omfatte virksomhedsdokumentation, produktkataloger, ofte stillede spørgsmål eller endda liveindholdet på et websted.

Relevant dokumentvalg: Hentesystemet identificerer de mest relevante dokumenter eller passager baseret på semantisk lighed med forespørgslen.

Kontekstforøgelse: Disse hentede dokumenter leveres til sprogmodellen som en ekstra kontekst, når dens svar genereres.

Responsgenerering: LLM producerer et svar, der inkorporerer både dets generelle sprogegenskaber og den specifikke hentede information.

Kildetilskrivning: Mange RAG-systemer sporer også, hvilke kilder der bidrog til svaret, hvilket muliggør citering eller verifikation.

Denne tilgang kombinerer det bedste fra begge verdener: LLM's evne til at forstå spørgsmål og generere naturligt sprog med nøjagtigheden og opdaterede oplysninger fra genfindingssystemer. Resultatet er en chatbot, der kan give specifikke, faktuelle oplysninger om produkter, politikker eller tjenester uden at ty til hallucinationer.

Overvej en chatbot for e-handelskundeservice. Når man bliver spurgt om returpolitikker for et specifikt produkt, kan en ren LLM generere et plausibelt, men potentielt forkert svar baseret på generelle mønstre, den observerede under træning. En RAG-forbedret chatbot ville i stedet hente virksomhedens faktiske returpolitikdokument, finde det relevante afsnit om den produktkategori og generere et svar, der nøjagtigt afspejler den aktuelle politik.

Sofistikeringen af RAG-systemer fortsætter med at udvikle sig. Moderne implementeringer bruger tætte vektorindlejringer til at repræsentere både forespørgsler og dokumenter i højdimensionelt semantisk rum, hvilket giver mulighed for genfinding baseret på mening snarere end blot søgeordsmatchning. Nogle systemer anvender rørledninger i flere trin, hvor de først kaster et bredt net og derefter forfiner resultaterne gennem omrangering. Andre bestemmer dynamisk, hvornår hentning er nødvendig i forhold til hvornår LLM'en sikkert kan svare ud fra sin parametriske viden.

For virksomheder, der implementerer chatbots, kræver effektiv RAG-implementering gennemtænkt videnbaseforberedelse – organisering af information i genfindbare bidder, regelmæssig opdatering af indhold og strukturering af data på måder, der letter nøjagtig hentning. Når det implementeres korrekt, forbedrer RAG dramatisk chatbot-nøjagtigheden, især for domænespecifikke applikationer, hvor præcision er afgørende.

Conversational State Management: Opretholdelse af kontekst

Moderne chatbots anvender sofistikerede samtaletilstandsstyringssystemer til at opretholde sammenhængende, kontekstuelle udvekslinger. Disse systemer sporer ikke kun det eksplicitte indhold af beskeder, men også den implicitte kontekst, som mennesker naturligt opretholder under samtaler.

Den mest grundlæggende form for statsstyring er sporing af samtalehistorik. Systemet opretholder en buffer af nylige udvekslinger (både brugerinput og dets egne svar), som leveres til sprogmodellen med hver ny forespørgsel. Men efterhånden som samtaler bliver længere, bliver hele historien inklusiv upraktisk på grund af kontekstlængdebegrænsningerne for selv de mest avancerede LLM'er.

For at løse denne begrænsning anvender sofistikerede chatbots flere teknikker:

Opsummering: Periodisk kondensering af tidligere dele af samtalen til kortfattede opsummeringer, der fanger nøgleoplysninger og reducerer tokenbrug.

Entitetssporing: Eksplicit overvågning af vigtige enheder (personer, produkter, problemer), der er nævnt under hele samtalen og vedligeholde dem i struktureret tilstand.

Opmærksomhed på samtalestadiet: Sporing af, hvor i et procesflow samtalen befinder sig i øjeblikket – uanset om der indsamles information, foreslås løsninger eller bekræftes handlinger.

Brugerkontekstvedholdenhed: Vedligeholdelse af relevante brugeroplysninger på tværs af sessioner, såsom præferencer, købshistorik eller kontooplysninger (med passende kontrolelementer til beskyttelse af personlige oplysninger).

Hensigtshukommelse: At huske brugerens oprindelige mål selv gennem samtaleomveje og afklaringer.

Overvej et kundeservicescenarie: En bruger begynder at spørge om at opgradere deres abonnementsplan og stiller derefter flere detaljerede spørgsmål om funktioner, prissammenligninger og faktureringscyklusser, før han endelig beslutter sig for at fortsætte med opgraderingen. Et effektivt styringssystem for samtaletilstand sikrer, at når brugeren siger "Ja, lad os gøre det", forstår chatbotten præcis, hvad "det" refererer til (opgraderingen) og har bevaret alle relevante detaljer fra den bugtende samtale.

Den tekniske implementering af statsstyring varierer på tværs af platforme. Nogle systemer bruger en hybrid tilgang, der kombinerer symbolsk tilstandssporing (eksplicit modellering af entiteter og hensigter) med de implicitte muligheder i store kontekstvinduer i moderne LLM'er. Andre anvender specialiserede hukommelsesmoduler, der selektivt henter relevante dele af samtalehistorikken baseret på den aktuelle forespørgsel.

Til komplekse applikationer som kundeservice eller salg integrerer statsadministration ofte med forretningsprocesmodellering, hvilket gør det muligt for chatbots at guide samtaler gennem definerede arbejdsgange og samtidig bevare fleksibiliteten til naturlig interaktion. De mest avancerede implementeringer kan endda spore følelsesmæssig tilstand sammen med faktuel kontekst, justere kommunikationsstil baseret på registreret brugerfølelse.

Effektiv kontekststyring forvandler chatbot-interaktioner fra afbrudte spørgsmål-svar-udvekslinger til ægte samtaler, der bygger på delt forståelse – en kritisk faktor i brugertilfredshed og fuldførelse af opgaver.

Naturlig sprogforståelse: Fortolkning af brugerhensigter

Moderne NLU-systemer i chatbots udfører typisk flere nøglefunktioner:

Hensigtsgenkendelse: Identifikation af brugerens underliggende mål eller formål. Forsøger brugeren at foretage et køb, rapportere et problem, anmode om oplysninger eller noget andet? Avancerede systemer kan genkende flere eller indlejrede hensigter i en enkelt besked.

Entity Extraction: Identifikation og kategorisering af specifikke stykker information i brugerens besked. For eksempel, i "Jeg skal ændre mit fly fra Chicago til Boston på torsdag" inkluderer enhederne steder (Chicago, Boston) og tid (torsdag).

Følelsesanalyse: Registrering af følelsesmæssig tone og attitude, som hjælper chatbotten med at tilpasse sin svarstil korrekt. Er brugeren frustreret, ophidset, forvirret eller neutral?

Sprogidentifikation: Bestemmelse af, hvilket sprog brugeren taler for at give passende svar i flersprogede miljøer.

Mens tidligere chatbot-platforme krævede eksplicit programmering af hensigter og entiteter, udnytter moderne systemer LLM'ernes iboende sprogforståelsesevner. Dette giver dem mulighed for at håndtere en meget bredere vifte af udtryk uden at kræve udtømmende opremsning af mulige fraseringer.

Når en bruger indtaster "Kasseprocessen bliver ved med at fryse på betalingssiden", vil et sofistikeret NLU-system identificere dette som en teknisk supporthensigt, udtrække "betalingsproces" og "betalingsside" som relevante enheder, opdage frustration i stemningen og dirigere denne information til den passende svargenereringsvej.

Nøjagtigheden af NLU påvirker brugertilfredsheden markant. Når en chatbot konsekvent fejlfortolker anmodninger, mister brugerne hurtigt tillid og tålmodighed. For at forbedre nøjagtigheden anvender mange systemer tillidsscoring - når tilliden til at forstå falder under visse tærskler, kan chatbotten stille opklarende spørgsmål i stedet for at fortsætte med potentielt forkerte antagelser.

Til domænespecifikke applikationer inkorporerer NLU-systemer ofte specialiseret terminologi og jargongenkendelse. En chatbot i sundhedssektoren ville for eksempel blive trænet til at genkende medicinske termer og symptomer, mens en bot for finansielle tjenester ville forstå bankterminologi og transaktionstyper.

Integrationen af NLU med de andre komponenter er afgørende. De udtrukne hensigter og entiteter informerer om genfindingsprocesser, hjælper med at opretholde en samtaletilstand og guider responsgenerering – og fungerer som det kritiske link mellem, hvad brugerne siger, og det, systemet gør.

Test AI på DIN hjemmeside på 60 sekunder

Se hvordan vores AI øjeblikkeligt analyserer din hjemmeside og skaber en personlig chatbot - uden registrering. Indtast blot din URL og se den arbejde!

Responsgenerering og optimering

I moderne systemer involverer responsgenerering typisk flere faser:

Responsplanlægning: Bestemmelse af, hvilke oplysninger der skal inkluderes, spørgsmål der skal stilles eller handlinger der skal foreslås baseret på den aktuelle samtaletilstand og tilgængelig viden.

Indholdsvalg: Valg af specifikke fakta, forklaringer eller muligheder, der skal præsenteres fra potentielt store sæt af relevant information.

Strukturering: Organisering af det valgte indhold i en logisk, nem at følge rækkefølge, der effektivt imødekommer brugerens behov.

Realisering: Konvertering af det planlagte indhold til et naturligt, flydende sprog, der matcher chatbottens ønskede tone og stil.

Selvom LLM'er kan generere imponerende sammenhængende tekst, fører ukontrolleret generering ofte til problemer som overdreven ordlyd, inklusion af irrelevant information eller svar, der ikke stemmer overens med forretningsmålene. For at løse disse problemer implementerer sofistikerede chatbot-systemer forskellige optimeringsteknikker:

Svarskabeloner: Til almindelige scenarier med forudsigelige informationsbehov bruger mange systemer parametriserede skabeloner, der sikrer ensartede, effektive svar, samtidig med at der er mulighed for personalisering.

Længdekontrol: Mekanismer til at justere svarlængden baseret på forespørgslens kompleksitet, platformen, hvor interaktionen finder sted, og brugerpræferencer.

Tone- og stilvejledning: Instruktioner, der justerer formaliteten, venligheden eller det tekniske niveau af svar baseret på samtalekonteksten og brugeregenskaber.

Planlægning af flere drejninger: For komplekse emner kan systemerne planlægge svar på tværs af flere drejninger og bevidst opdele information i fordøjelige bidder i stedet for at overvælde brugere med tekstvægge.

Business Logic Integration: Regler, der sikrer, at svar stemmer overens med forretningspolitikker, lovgivningsmæssige krav og servicemuligheder.

De mest effektive chatbots anvender også adaptive responsstrategier. De overvåger brugerengagement og tilfredshedssignaler for at forfine deres kommunikationstilgang over tid. Hvis brugere ofte beder om afklaring efter en bestemt type svar, justerer systemet muligvis automatisk for at give mere detaljerede forklaringer i lignende fremtidige scenarier.

Et afgørende aspekt af responsgenerering er at håndtere usikkerhed. Når information er utilgængelig eller tvetydig, anerkender veldesignede systemer begrænsninger i stedet for at generere selvsikkert klingende, men potentielt forkerte svar. Denne gennemsigtighed opbygger tillid og styrer brugernes forventninger effektivt.

For missionskritiske applikationer som sundhedspleje eller finansielle tjenester inkluderer mange implementeringer menneskelige gennemgangsmekanismer for visse typer svar, før de når brugerne. Disse autoværn giver et ekstra lag af kvalitetskontrol til interaktioner med høj indsats.

Specialiserede moduler til handlinger og integration

Disse handlingsmuligheder implementeres gennem specialiserede moduler, der forbinder samtalegrænsefladen med eksterne systemer:

API Integration Framework: Et middleware-lag, der oversætter samtaleanmodninger til korrekt formaterede API-kald til forskellige backend-tjenester – bestillingssystemer, CRM-platforme, betalingsprocessorer, reservationssystemer osv.

Godkendelse og autorisation: Sikkerhedskomponenter, der bekræfter brugeridentitet og tilladelsesniveauer, før de udfører følsomme handlinger eller får adgang til beskyttet information.

Assistance til formularudfyldning: Moduler, der hjælper brugere med at udfylde komplekse formularer gennem samtaleinteraktion, ved at indsamle nødvendige oplysninger stykke for stykke i stedet for at præsentere overvældende formularer.

Transaktionsbehandling: Komponenter, der håndterer flertrinsprocesser som køb, reservationer eller kontoændringer, opretholder tilstand gennem hele processen og håndterer undtagelser med ynde.

Notifikationssystemer: Mulighed for at sende opdateringer, bekræftelser eller advarsler gennem forskellige kanaler (e-mail, SMS, meddelelser i appen), efterhånden som handlinger skrider frem eller fuldføres.

Sofistikeringen af disse integrationer varierer meget på tværs af implementeringer. Simple chatbots kan inkludere grundlæggende "handoff"-funktionalitet, der overfører brugere til menneskelige agenter eller specialiserede systemer, når handling er påkrævet. Mere avancerede implementeringer tilbyder problemfri end-to-end-oplevelser, hvor chatbotten håndterer hele processen i samtalen.

Overvej en flyselskabs chatbot, der hjælper en passager med at ændre en flyvning. Det skal:

Autentificer brugeren og hent deres reservation

Søg efter tilgængelige alternative flyvninger

Beregn eventuelle prisforskelle eller ændringsgebyrer

Behandle betaling om nødvendigt

Udsted nye boardingkort

Opdater reservationen i flere systemer

Send bekræftelsesdetaljer gennem foretrukne kanaler

For at opnå dette kræver det integration med reservationssystemer, betalingsprocessorer, godkendelsestjenester og notifikationsplatforme – alt sammen orkestreret af chatbotten og samtidig opretholde et naturligt samtaleflow.

For virksomheder, der bygger handlingsorienterede chatbots, repræsenterer dette integrationslag ofte den mest omfattende udviklingsindsats. Mens samtalekomponenterne drager fordel af fremskridt inden for AI til generelle formål, skal disse integrationer skræddersyes til hver organisations specifikke systemlandskab.

Sikkerhedshensyn er især vigtige for action-kompatible chatbots. Bedste praksis omfatter implementering af korrekt godkendelse før følsomme operationer, vedligeholdelse af detaljerede revisionslogfiler over alle udførte handlinger, levering af klare bekræftelsestrin for efterfølgende aktiviteter og udformning af elegant fejlhåndtering, når integrationer støder på problemer.

Efterhånden som disse integrationsmuligheder udvikler sig, bliver grænsen mellem samtalegrænseflader og traditionelle applikationer fortsat udvisket. De mest sofistikerede implementeringer i dag giver brugerne mulighed for at udføre komplekse opgaver udelukkende gennem naturlig samtale, som tidligere ville have krævet at navigere på flere skærme i traditionelle applikationer.

Træning og løbende forbedringer

Flere tilgange til træning og forbedringsarbejde i forening:

Finjustering af basismodel: Basissprogmodellerne, der driver chatbots, kan specialiseres yderligere gennem yderligere træning i domænespecifikke data. Denne proces, kaldet finjustering, hjælper modellen med at vedtage passende terminologi, ræsonnementmønstre og domæneviden til specifikke applikationer.

Forstærkende læring fra menneskelig feedback (RLHF): Denne teknik bruger menneskelige evaluatorer til at bedømme modelsvar og skabe præferencedata, der træner belønningsmodeller. Disse belønningsmodeller guider derefter systemet mod at generere mere nyttige, nøjagtige og sikre output. RLHF har været afgørende for at flytte sprogmodeller fra imponerende, men upålidelige generatorer til praktiske assistenter.

Conversation Mining: Analysesystemer, der behandler anonymiserede samtalelogfiler for at identificere mønstre, almindelige spørgsmål, hyppige fejlpunkter og vellykkede løsningsstier. Disse indsigter driver både automatiserede forbedringer og vejleder menneskestyrede forbedringer.

Aktiv læring: Systemer, der identificerer områder med usikkerhed og markerer disse tilfælde til menneskelig gennemgang, og fokuserer menneskelig indsats på de mest værdifulde forbedringsmuligheder.

A/B-testning: Eksperimentelle rammer, der sammenligner forskellige responsstrategier med rigtige brugere for at bestemme, hvilke tilgange der er mest effektive til forskellige scenarier.

For virksomheds chatbots begynder træningsprocessen typisk med historiske data – tidligere kundeserviceudskrifter, dokumentation og produktinformation. Denne indledende træning suppleres derefter med omhyggeligt designede eksempelsamtaler, der demonstrerer ideel håndtering af almindelige scenarier.

Når de er implementeret, inkluderer effektive systemer feedbackmekanismer, der giver brugerne mulighed for at angive, om svarene var nyttige. Denne feedback, kombineret med implicitte signaler som samtaleopgivelse eller gentagne spørgsmål, skaber et rigt datasæt til løbende forbedringer.

Den menneskelige rolle i træningen af moderne chatbots er fortsat afgørende. Samtaledesignere laver kernepersonligheden og kommunikationsmønstrene. Emneeksperter gennemgår og retter foreslåede svar for teknisk nøjagtighed. Dataforskere analyserer præstationsmålinger for at identificere forbedringsmuligheder. De mest succesrige implementeringer behandler chatbot-udvikling som et samarbejdende menneske-AI-partnerskab snarere end en fuldt automatiseret proces.

For virksomheder, der implementerer chatbots, er det afgørende at etablere en klar forbedringsramme. Dette omfatter:

Regelmæssige præstationsgennemgange

Dedikeret personale til overvågning og forfining

Klare metrics for succes

Processer til at indarbejde brugerfeedback

Governance til styring af uddannelsesdatakvalitet

Mens de specifikke tilgange varierer på tværs af platforme og applikationer, forbliver det grundlæggende princip konsekvent: moderne chatbots er dynamiske systemer, der forbedres gennem brug, feedback og bevidst forfining snarere end statiske programmer, der er låst fast i deres oprindelige muligheder.

Sikkerhedsforanstaltninger og etiske overvejelser

Disse sikkerhedsforanstaltninger omfatter typisk:

Indholdsfiltrering: Systemer, der registrerer og forhindrer skadeligt, stødende eller upassende indhold i både brugerinput og modeloutput. Moderne implementeringer bruger specialiserede modeller, der er specielt trænet til at identificere problematisk indhold på tværs af forskellige kategorier.

Håndhævelse af omfang: Mekanismer, der holder samtaler inden for passende domæner, forhindrer chatbots i at blive manipuleret til at give råd eller information uden for deres tilsigtede formål og ekspertise.

Databeskyttelseskontrol: Beskyttelse af følsomme brugeroplysninger, herunder dataminimeringsprincipper, anonymiseringsteknikker og eksplicitte samtykkemekanismer til datalagring eller -brug.

Bias Mitigation: Processer, der identificerer og reducerer uretfærdige skævheder i træningsdata og modeloutput, hvilket sikrer ligebehandling på tværs af forskellige brugergrupper.

Ekstern referencebekræftelse: For faktuelle påstande, især i følsomme domæner, systemer, der verificerer oplysninger mod betroede eksterne kilder, før de præsenteres for brugerne.

Menneskelig tilsyn: For kritiske applikationer, gennemgå mekanismer, der muliggør menneskelig overvågning og indgriben, når det er nødvendigt, især for konsekvente beslutninger eller følsomme emner.

Gennemførelsen af disse sikkerhedsforanstaltninger involverer både tekniske og politiske komponenter. På det tekniske niveau arbejder forskellige filtreringsmodeller, detektionsalgoritmer og overvågningssystemer sammen for at identificere problematiske interaktioner. På politikniveau definerer klare retningslinjer passende use cases, påkrævede ansvarsfraskrivelser og eskaleringsstier.

Healthcare chatbots giver et klart eksempel på disse principper i aktion. Veldesignede systemer på dette domæne inkluderer typisk eksplicitte ansvarsfraskrivelser om deres begrænsninger, undgår diagnostisk sprogbrug, medmindre det er medicinsk valideret, opretholder streng privatlivskontrol for sundhedsoplysninger og inkluderer klare eskaleringsstier til medicinske fagfolk for passende bekymringer.

For virksomheder, der implementerer chatbots, er der dukket adskillige bedste praksis op:

Start med klare etiske retningslinjer og brug case-grænser

Implementer flere lag af sikkerhedsmekanismer i stedet for at stole på en enkelt tilgang

Test omfattende med forskellige brugergrupper og scenarier

Etablere overvågnings- og hændelsesprotokoller

Giv brugerne gennemsigtig information om systemets muligheder og begrænsninger

Efterhånden som konversations-AI bliver mere kraftfuld, øges betydningen af disse sikkerhedsforanstaltninger kun. De mest succesrige implementeringer balancerer innovation med ansvar og sikrer, at chatbots forbliver nyttige værktøjer, der forbedrer menneskelige evner i stedet for at skabe nye risici eller skader.

Fremtiden for Chatbot-teknologi

Multimodale muligheder: Den næste generation af chatbots vil bevæge sig ud over tekst til problemfrit at inkorporere billeder, stemme, video og interaktive elementer. Brugere vil være i stand til at vise problemer gennem deres kamera, høre forklaringer med visuelle hjælpemidler og interagere gennem det medie, der er mest praktisk for deres aktuelle kontekst.

Agentadfærd: Avancerede chatbots bevæger sig fra reaktiv besvarelse af spørgsmål til proaktiv problemløsning. Disse "agentiske" systemer kan tage initiativ, dele komplekse opgaver op i trin, bruge værktøjer til at indsamle information og fortsætte, indtil målene er nået – mere som virtuelle assistenter end simple chatbots.

Hukommelse og personalisering: Fremtidige systemer vil opretholde mere sofistikeret langtidshukommelse af brugerpræferencer, tidligere interaktioner og relationshistorie. Denne vedvarende forståelse vil muliggøre stadig mere personlige oplevelser, der tilpasser sig individuelle kommunikationsstile, vidensniveauer og behov.

Specialiserede domæneeksperter: Selvom chatbots til generelle formål vil fortsætte med at blive bedre, ser vi også fremkomsten af højt specialiserede systemer med dyb ekspertise inden for specifikke domæner – juridiske assistenter med omfattende viden om retspraksis, medicinske systemer uddannet i klinisk litteratur eller finansielle rådgivere, der er fortrolige med skatteregler og -regler.

Collaborative Intelligence: Grænsen mellem menneskelige og AI-ansvar vil fortsætte med at udviskes med mere sofistikerede samarbejdsmodeller, hvor chatbots og menneskelige eksperter arbejder problemfrit sammen, og hver især håndterer aspekter af kundeinteraktion, hvor de udmærker sig.

Følelsesmæssig intelligens: Fremskridt i affektgenkendelse og passende generering af følelsesmæssig respons vil skabe mere naturligt empatiske interaktioner. Fremtidige systemer vil bedre genkende subtile følelsesmæssige signaler og reagere med passende følsomhed over for brugernes behov.

Federated and On-Device Processing: Bekymringer om beskyttelse af personlige oplysninger driver udviklingen af arkitekturer, hvor mere behandling sker lokalt på brugerenheder, med færre data, der overføres til centrale servere. Denne tilgang lover bedre beskyttelse af privatlivets fred og samtidig bevare sofistikerede funktioner.

Disse fremskridt vil muliggøre nye applikationer på tværs af brancher. I sundhedsvæsenet kan chatbots fungere som kontinuerlige sundhedsledsager, overvåge forhold og koordinere pleje på tværs af udbydere. I uddannelse kan de fungere som personlige vejledere, der tilpasser sig individuelle læringsstile og fremskridt. I professionelle tjenester kunne de blive specialiserede forskningsassistenter, der dramatisk forstærker menneskelig ekspertise.

Disse evner vil dog også medføre nye udfordringer. Mere kraftfulde systemer vil kræve mere sofistikerede sikkerhedsmekanismer. Stadig mere menneskelignende interaktioner vil rejse nye spørgsmål om passende offentliggørelse af AI-identitet. Og efterhånden som disse systemer bliver mere integrerede i dagligdagen, vil sikring af lige adgang og forebyggelse af skadelige afhængigheder blive vigtige sociale overvejelser.

Hvad der synes klart er, at grænsen mellem chatbots og andre softwaregrænseflader vil fortsætte med at udviskes. Naturligt sprog er simpelthen den mest intuitive grænseflade til mange menneskelige behov, og efterhånden som samtale-AI bliver mere dygtig, vil det i stigende grad blive standardmåden, vi interagerer med digitale systemer. Fremtiden handler ikke kun om bedre chatbots – det handler om, at samtale bliver det primære menneske-computer-interface for mange applikationer.

Konklusion: Den løbende samtale

Moderne chatbots repræsenterer en af de mest synlige og virkningsfulde anvendelser af kunstig intelligens i hverdagen. Bag deres tilsyneladende simple chat-grænseflader ligger et sofistikeret orkester af teknologier, der arbejder sammen: Grundlæggende modeller, der giver sprogforståelse, genfindingssystemer, der jorder svar i nøjagtig information, statens ledelse opretholder sammenhængende samtaler, integrationslag, der forbinder til forretningssystemer, og sikkerhedsmekanismer, der sikrer passende adfærd.

Denne komplekse arkitektur muliggør oplevelser, der ville have virket som science fiction for bare et årti siden – naturlige samtaler med digitale systemer, der kan besvare spørgsmål, løse problemer og udføre handlinger på vores vegne. Og alligevel er vi stadig i de tidlige kapitler af denne teknologis udvikling. Konversations-AI's muligheder og anvendelser vil fortsætte med at udvide sig hurtigt i de kommende år.

For virksomheder og organisationer, der ønsker at implementere chatbot-teknologi, er forståelsen af disse underliggende komponenter afgørende for at sætte realistiske forventninger, træffe informerede designvalg og skabe virkelig værdifulde brugeroplevelser. De mest succesrige implementeringer behandler ikke chatbots som magiske sorte bokse, men snarere som sofistikerede værktøjer, hvis muligheder og begrænsninger skal håndteres omhyggeligt.

For brugere, der interagerer med disse systemer, kan et glimt bag gardinet hjælpe med at afmystificere, hvad der nogle gange føles som teknologisk magi. At forstå de grundlæggende principper for, hvordan moderne chatbots fungerer, muliggør mere effektiv interaktion – at vide, hvornår de kan hjælpe, hvornår de kan kæmpe, og hvordan man kommunikerer med dem bedst muligt.

Det, der måske er mest bemærkelsesværdigt ved chatbot-teknologi, er, hvor hurtigt vores forventninger tilpasser sig. Funktioner, der ville have overrasket os for et par år siden, bliver hurtigt den baseline, vi tager for givet. Denne hurtige normalisering taler om, hvor naturligt samtale fungerer som en grænseflade – når det gøres godt, forsvinder det simpelthen, hvilket efterlader os fokuseret på at løse problemer og få tingene gjort frem for at tænke på selve teknologien.

Efterhånden som disse systemer fortsætter med at udvikle sig, vil samtalen mellem mennesker og maskiner blive mere og mere problemfri og produktiv – ikke erstatte menneskelig forbindelse, men øge vores evner og frigøre os til at fokusere på de unikke menneskelige aspekter af vores arbejde og liv.