Test DIN Virksomhed på Minutter

Opret din konto og lancér din AI-chatbot på få minutter. Fuldt tilpasselig, ingen kodning påkrævet - begynd at engagere dine kunder øjeblikkeligt!

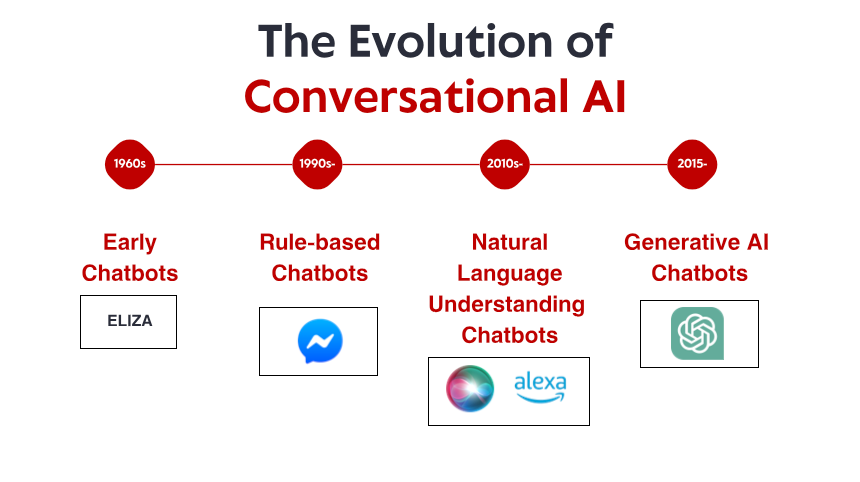

Introduktion: Det udviklende landskab inden for NLP-udvikling

Det seneste år har set bemærkelsesværdige fremskridt inden for NLP-teknologi - fra mere effektive finjusteringsmetoder til multimodale funktioner, der bygger bro mellem tekst og andre datatyper. Runtime-effektivitet er blevet stadig vigtigere, efterhånden som flere NLP-arbejdsbyrder flyttes til edge-enheder og forbrugerhardware. I mellemtiden er specialiserede domænefunktioner udvidet til at betjene brancher fra sundhedspleje til juridiske tjenester med hidtil uset nøjagtighed.

Uanset om du bygger en samtalemedarbejder, analyserer kundefeedback, udtrækker indsigt fra dokumenter eller opretter værktøjer til indholdsgenerering, kan valget af det rigtige NLP-bibliotek have en dramatisk indflydelse på dit projekts succes. Denne guide undersøger de syv mest effektive NLP-biblioteker i 2025 og sammenligner deres styrker, begrænsninger og ideelle use cases for at hjælpe dig med at træffe en informeret beslutning til dit næste udviklingsprojekt.

1. Hugging Face Transformers 6.0: Det omfattende økosystem

Nøglefunktioner og forbedringer

Den seneste version introducerer adskillige banebrydende funktioner:

Effektiv finjusteringsramme: Det nye EFT-modul reducerer beregningskravene betydeligt for at tilpasse grundlæggende modeller til specifikke opgaver. Modeller, der tidligere krævede flere GPU'er til finjustering, kan nu tilpasses på forbrugerhardware med minimale kompromiser med ydeevnen.

Multimodale pipelines: Transformers tilbyder nu strømlinede pipelines til at bygge applikationer, der problemfrit kombinerer tekstanalyse med billed-, lyd- og endda videoforståelse – perfekt til at skabe mere kontekstbevidste applikationer.

Virksomhedsbaserede implementeringsværktøjer: Det nye implementeringsværktøjssæt forenkler flytning af modeller fra forskning til produktion med automatiseret optimering til forskellige hardwaremål, fra serverklynger til mobile enheder.

Domænespecialiseringspakker: Forudkonfigurerede indstillinger og modeller til specifikke brancher som sundhedsvæsen, jura og finans giver udviklere mulighed for at starte med domæneoptimerede fundamenter i stedet for generiske modeller.

Hvorfor udviklere elsker det

Transformers fortsætter med at dominere, fordi det finder en exceptionel balance mellem tilgængelighed og banebrydende funktioner. Den veldokumenterede API gør det nemt for nybegyndere at implementere avancerede NLP-funktioner, mens de omfattende tilpasningsmuligheder opfylder behovene hos erfarne ML-ingeniører.

Det pulserende fællesskab omkring Hugging Face betyder også, at løsninger på almindelige problemer normalt kun er en forumsøgning væk, hvilket reducerer udviklingstiden betydeligt. Med over 75.000 foruddannede modeller nu tilgængelige i Model Hub, kan udviklere ofte finde specialiserede modeller, der matcher deres use case-krav, uden at starte fra bunden.

Ideelle anvendelsesscenarier

Hugging Face Transformers 6.0 udmærker sig ved:

Forskningsprojekter, der kræver hurtig eksperimentering med forskellige modelarkitekturer

Produktionsapplikationer, der kræver avanceret sprogforståelse

Teams, der ønsker at udnytte fællesskabets viden og ressourcer

Projekter, der kræver specialiseret domæneviden (sundhedspleje, jura, finans)

Applikationer, der kræver multimodale funktioner

Overvejelser

Selvom Transformers stadig er den mest alsidige mulighed, er det ikke altid det mest ressourceeffektive valg til implementering. Nogle udviklere rapporterer, at den generaliserede arkitektur introducerer overhead, som specialiserede biblioteker undgår. Derudover betyder den hurtigt udviklende kodebase lejlighedsvise ændringer mellem større versioner.

2. SpaCy 4.0: Produktionsklar effektivitet

Nøglefunktioner og forbedringer

SpaCy 4.0 bringer betydelige forbedringer:

Transformer-integration: De opdaterede transformer pipeline-komponenter fungerer nu native med de nyeste modeller, samtidig med at SpaCys effektive behandlingsarkitektur opretholdes.

Forbedret multiprocessing: Nye parallelle behandlingsfunktioner giver næsten lineær skalering til dokumentbehandlingsopgaver, hvilket gør SpaCy velegnet til batchbehandling af enorme tekstsamlinger.

Udvidet struktureret forudsigelse: Ud over navngiven entitetsgenkendelse og afhængighedsparsing tilbyder SpaCy nu forbedret understøttelse af brugerdefinerede strukturerede forudsigelsesopgaver gennem en mere fleksibel annotations- og træningsramme.

Slankere runtime-krav: På trods af de øgede funktioner kan kernebehandlingspipelines nu køre med betydeligt reduceret hukommelsesfodaftryk – afgørende for implementering i ressourcebegrænsede miljøer.

Forbedret regelmotor: Mønstermatchningssystemet er blevet fuldstændig renoveret og tilbyder nu mere kraftfulde udtryk, samtidig med at matchningshastigheden er forbedret med op til 300%.

Hvorfor udviklere vælger det

SpaCy er fortsat det foretrukne valg til produktionssystemer, fordi det leverer industriel ydeevne med en udviklervenlig API. Den gennemtænkte objektorienterede arkitektur gør det nemt at integrere i større applikationer, samtidig med at den opretholder ensartet ydeevne.

Det nye "SpaCy Projects"-framework har også forenklet pakningen og implementeringen af end-to-end NLP-pipelines, hvilket giver teams mulighed for at standardisere deres udviklingsworkflows fra eksperimentering til produktion.

Ideelle anvendelsesscenarier

SpaCy 4.0 er perfekt til:

Tekstbehandlingssystemer med høj kapacitet

Produktionsmiljøer, hvor pålidelighed og forudsigelighed er afgørende

Applikationer, der kræver navngiven entitetsgenkendelse og relationsudtrækning af industriel styrke

Projekter med implementeringsbegrænsninger (hukommelse, processorkraft)

Teams, der har brug for både klassiske NLP-funktioner og moderne neurale tilgange

Overvejelser

Selvom SpaCy har gjort store fremskridt med at inkorporere transformermodeller, tilbyder det stadig ikke den samme bredde af banebrydende forskningsimplementeringer som Hugging Face. Derudover finder nogle udviklere dens påståede arkitektur mindre fleksibel til meget tilpassede forskningsapplikationer.

3. Cohere SDK: API-første sprogintelligens

Nøglefunktioner og forbedringer

Cohere-platformen tilbyder adskillige overbevisende funktioner:

Command- og Command-R-modeller: Disse modeller udmærker sig ved at følge specifikke instruktioner og forstå nuancerede anmodninger, hvilket gør dem ideelle til at bygge værktøjer, der reagerer præcist på brugerforespørgsler.

Integreringsmodeller: Den seneste generation af integreringsmodeller skaber bemærkelsesværdigt præcise semantiske repræsentationer, der overgår tidligere tilgange til hentnings- og klassificeringsopgaver betydeligt.

Virksomhedstilpasning: For organisationer med specifikke behov tilbyder Cohere nu tilpasningsmuligheder, der tilpasser deres kernemodeller til specialiserede domæner uden at kræve massive træningsdatasæt.

Flersproget understøttelse: Robuste funktioner på tværs af over 100 sprog muliggør globale applikationer uden behov for separate modeller for hvert sprog.

Ansvarlig AI-kontrol: Indbyggede sikkerhedsfiltre og biasdetektion hjælper udviklere med at skabe systemer, der opfylder stadig vigtigere etiske standarder.

Hvorfor udviklere vælger det

Cohere SDK har vundet frem, primært fordi det dramatisk sænker barrieren for implementering af sofistikerede NLP-funktioner. Udviklere uden maskinlæringsekspertise kan tilføje avanceret sprogforståelse til applikationer med minimal kode, samtidig med at de stadig har finjusteret kontrol over modellens adfærd, når det er nødvendigt.

API-først-tilgangen betyder også, at teams ikke behøver at bekymre sig om infrastrukturstyring eller at holde sig ajour med de seneste forskningsfremskridt - Cohere håndterer disse aspekter, hvilket giver udviklere mulighed for at fokusere på deres applikationslogik.

Ideelle brugsscenarier

Cohere SDK er fremragende til:

Startups og teams uden dedikeret ML-infrastruktur

Applikationer, der skal skaleres hurtigt uden at administrere modelimplementering

Projekter, der kræver pålidelighed og support i virksomhedsklasse

Flersprogede applikationer, der betjener globale markeder

Brugsscenarier, hvor ansvarlig AI-praksis er en prioritet

Overvejelser

Det primære kompromis med Cohere er, at udviklere er afhængige af en tredjepartstjeneste i stedet for at køre modeller i deres egen infrastruktur. Dette skaber potentielle bekymringer omkring databeskyttelse, tjenestetilgængelighed og langsigtet prisstabilitet. Nogle udviklere bemærker også, at den API-baserede tilgang, selvom den er praktisk, nogle gange begrænser fleksibiliteten sammenlignet med at have direkte adgang til modellens interne elementer.

4. PyTorch NLP (torchtext 3.0): Forskerens valg

Nøglefunktioner og forbedringer

Den seneste version bringer flere betydelige opgraderinger:

Native understøttelse af transformerarkitekturer: Førsteklasses implementeringer af opmærksomhedsmekanismer og transformerblokke gør det nemmere at implementere brugerdefinerede arkitekturer.

Optimerede databehandlingsrørledninger: Nye vektoriserede tekstbehandlingsoperationer udnytter moderne CPU'er og GPU'er mere effektivt og fremskynder forbehandlingstrin dramatisk.

Forbedret Transfer Learning Framework: Den raffinerede API gør det nemt at tilpasse forudtrænede modeller til nye opgaver, samtidig med at den opretholder præcis kontrol over træningsprocessen.

Kvantiserings- og beskæringsværktøjer: Indbyggede funktioner til modelkomprimering gør det muligt for forskere at reducere modelstørrelse og inferenstid uden overdreven forringelse af ydeevnen.

Forbedret batchbehandling: Smartere batchstrategier til sekvenser med variabel længde resulterer i mere effektiv GPU-udnyttelse under træning.

Hvorfor forskere og udviklere vælger det

PyTorch NLP er fortsat det foretrukne valg til forskning og specialiserede applikationer, fordi det tilbyder maksimal fleksibilitet uden at gå på kompromis med brugervenligheden. Den imperative programmeringsstil stemmer overens med, hvordan de fleste udviklere tænker, hvilket gør det lettere at debugge modeller og eksperimentere med nye tilgange.

Den problemfri integration med det bredere PyTorch-økosystem betyder også, at fremskridt inden for generel dyb læring (som optimeringsteknikker eller træningsmetoder) er øjeblikkeligt anvendelige på NLP-opgaver.

Ideelle brugsscenarier

PyTorch NLP er bedst egnet til:

Forskningsprojekter, der udforsker nye arkitekturer eller træningsmetoder

Applikationer, der kræver tilpasset modeladfærd, som ikke er tilgængelig i biblioteker på højere niveau

Uddannelsesmæssige sammenhænge, hvor forståelse af modelinternals er vigtig

Projekter, hvor integration med computer vision eller andre modaliteter er nødvendig

Situationer, der kræver maksimal kontrol over træningsprocessen

Overvejelser

Fleksibiliteten ved PyTorch NLP kommer med en stejlere læringskurve og mere implementeringsansvar. Udviklere skal træffe flere arkitektoniske beslutninger og implementere flere komponenter fra bunden sammenlignet med biblioteker på højere niveau. Derudover kræver nogle produktionsoptimeringsfunktioner yderligere arbejde for at blive implementeret korrekt.

Test DIN Virksomhed på Minutter

Opret din konto og lancér din AI-chatbot på få minutter. Fuldt tilpasselig, ingen kodning påkrævet - begynd at engagere dine kunder øjeblikkeligt!

5. JAX NLP (FLAX/Prax): Ydeevne i stor skala

Nøglefunktioner og forbedringer

JAX's NLP-økosystem tilbyder flere karakteristiske fordele:

Transparent XLA-kompilering: Automatisk optimering til TPU'er, GPU'er og specialiseret hardware leverer bemærkelsesværdige forbedringer af trænings- og inferenshastighed.

Funktionel programmeringsmodel: Den rene funktionelle tilgang forenkler distribution på tværs af flere enheder og hjælper med at undgå subtile træningsfejl.

Avanceret parallelisme: Indbygget understøttelse af model-, data- og pipeline-parallelisme gør træning af massive modeller mere tilgængelig.

Hardwarespecifikke optimeringer: Specialiserede implementeringer drager fuld fordel af de nyeste acceleratorfunktioner fra forskellige hardwareleverandører.

Differentiel privatlivsintegration: Indbygget understøttelse af private træningsmetoder imødekommer voksende lovgivningsmæssige krav omkring databeskyttelse.

Hvorfor teams vælger det

Organisationer, der arbejder med ekstremt store modeller eller datasæt, vælger primært JAX-baserede løsninger på grund af ydeevnefordelene. Modeller, der ville tage uger at træne på andre frameworks, kan ofte færdiggøres på få dage med JAX, hvilket repræsenterer betydelige omkostningsbesparelser i cloud computing-ressourcer.

Den funktionelle tilgang giver også fordele for reproducerbarhed og fejlfinding, hvilket bliver stadig vigtigere, efterhånden som modeller vokser i kompleksitet, og træningskørsler bliver dyrere.

Ideelle anvendelsesscenarier

JAX NLP er ideel til:

Træning og implementering af meget store sprogmodeller

Organisationer med adgang til specialiseret hardware (TPU'er osv.)

Projekter, der kræver maksimal beregningseffektivitet

Situationer, hvor reproducerbarhed er kritisk

Applikationer, der kræver strenge privatlivsgarantier

Overvejelser

JAX's programmeringsmodel er, selvom den er kraftfuld, en betydelig afvigelse fra de mere velkendte objektorienterede tilgange fra andre frameworks. Dette kan øge den indledende læringskurve, især for udviklere uden en stærk funktionel programmeringsbaggrund. Derudover har økosystemet, selvom det vokser hurtigt, stadig færre brugsklare komponenter end mere etablerede frameworks.

6. TensorFlow Text 3.0: Virksomhedsstabilitet

Nøglefunktioner og forbedringer

TensorFlow Text 3.0 leverer flere vigtige forbedringer:

Integration med TF Extended: Problemfri forbindelse med TensorFlows produktions-ML-pipelineværktøjer forenkler rejsen fra eksperimentering til implementering.

Forbedret TFLite-understøttelse: Forbedrede tekstbehandlingsoperationer i TFLite gør implementering af NLP-modeller til mobile og edge-enheder mere praktisk.

Konsekvent Cross-Platform-oplevelse: De samme modeller og behandlingspipelines fungerer pålideligt på tværs af trænings- og inferensmiljøer, fra cloud-TPU'er til mobile enheder.

Udvidet Enterprise-integration: Native connectors til almindelige virksomhedsdatakilder forenkler integration af tekstbehandling i eksisterende arbejdsgange.

Omfattende visningsmuligheder: Fra TF Serving til SavedModel til TFLite dækker implementeringsmulighederne stort set ethvert målmiljø.

Hvorfor organisationer vælger det

TensorFlow Text er fortsat populært i virksomhedsmiljøer, fordi det tilbyder en komplet løsning fra dataforberedelse til implementering. API'ens stabilitet og de omfattende implementeringsmuligheder reducerer risikoen forbundet med at integrere NLP i missionskritiske applikationer.

Integrationen med Googles cloud-tilbud giver også en ligetil skaleringsvej for organisationer, der allerede er investeret i dette økosystem.

Ideelle anvendelsesscenarier

TensorFlow Text 3.0 udmærker sig ved:

Virksomhedsapplikationer, der kræver produktionsstabilitet

Mobile og edge-implementeringsscenarier

Organisationer med eksisterende TensorFlow-investeringer

Projekter, der kræver omfattende ML-pipelines

Applikationer, hvor implementeringsfleksibilitet er afgørende

Overvejelser

Selvom TensorFlow Text fortsætter med at tilføje nye funktioner, halter det nogle gange bagefter andre frameworks i implementeringen af de seneste forskningsfremskridt. Derudover finder nogle udviklere den symbolske programmeringsmodel mindre intuitiv til eksperimentering sammenlignet med PyTorchs imperative tilgang.

7. Flair 2.0: NLP-schweizerkniven

Nøglefunktioner og forbedringer

Flair 2.0 bringer flere bemærkelsesværdige forbedringer:

Hybrid Embeddings Framework: Kombiner nemt forskellige typer af indlejringer (kontekstuelle, statiske, tegnniveau) for at opnå optimal ydeevne til specifikke opgaver.

One-Shot Learning-funktioner: Nye få-shot-læringsteknikker leverer overraskende gode resultater på specialiserede opgaver med minimale mærkede data.

Forbedret dokumentintelligens: Forbedrede dokumentmodelleringsmetoder indfanger bedre langsigtede afhængigheder i lange tekster.

Strømlinet finjustering: Forenklede arbejdsgange til tilpasning af forudtrænede modeller til specifikke domæner eller opgaver.

Lettere ressourcekrav: Forbedret effektivitet gør Flair velegnet til implementering på mindre kraftfuld hardware.

Hvorfor udviklere vælger det

Flair har fået en dedikeret fanskare, fordi det rammer en fremragende balance mellem kraft og enkelhed. Biblioteket tilbyder næsten topmoderne ydeevne til mange almindelige NLP-opgaver, samtidig med at det kræver betydeligt færre kode- og beregningsressourcer end tungere frameworks.

Det intuitive API-design gør det også tilgængeligt for udviklere, der ikke er NLP-specialister, hvilket giver dem mulighed for at integrere sofistikeret sprogforståelse i deres applikationer med en relativt let indlæringskurve.

Ideelle anvendelsesscenarier

Flair 2.0 fungerer bedst til:

Projekter, der kræver fremragende sekvensmærkning (NER, POS-tagging)

Applikationer med begrænsede beregningsressourcer

Teams, der søger hurtig implementering af standard NLP-opgaver

Scenarier med minimale mærkede træningsdata

Specialiserede tekstklassificeringsapplikationer

Overvejelser

Selvom Flair fortsætter med at udvide sine muligheder, tilbyder det ikke den samme bredde af modeller og teknikker som større frameworks som Hugging Face Transformers. Derudover bemærker nogle udviklere, at dets dokumentation, selvom den forbedres, stadig mangler de omfattende eksempler, der findes i mere etablerede biblioteker.

Konklusion: Valg af det rigtige NLP-bibliotek til dine behov

Hugging Face Transformers 6.0 leverer det mest omfattende økosystem og modeludvalg

SpaCy 4.0 leverer industriel stærk ydeevne og produktionspålidelighed

Cohere SDK tilbyder API-first bekvemmelighed med løbende opdaterede modeller

PyTorch NLP giver forskere maksimal fleksibilitet og kontrol

JAX NLP leverer uovertruffen ydeevne til store applikationer

TensorFlow Text 3.0 giver virksomhedsstabilitet og implementeringsmuligheder

Flair 2.0 kombinerer imponerende funktioner i en letvægtspakke

Det rigtige valg afhænger af dine specifikke krav:

Til hurtig prototyping og adgang til avancerede modeller er Hugging Face Transformers fortsat svær at slå. Hvis produktionspålidelighed og effektivitet er dine primære bekymringer, fortsætter SpaCy med at udmærke sig. Når udviklingshastighed og nem implementering betyder mest, tilbyder Coheres API-first-tilgang overbevisende fordele.

Forskere, der kræver maksimal fleksibilitet, vil stadig tiltrækkes af PyTorch NLP, mens organisationer, der træner massive modeller, vil drage fordel af JAX's ydeevneoptimeringer. Virksomheder, der værdsætter stabilitet og omfattende implementeringsmuligheder, finder TensorFlow Text et sikkert valg, og teams, der leder efter en letvægtsløsning med imponerende funktioner, bør overveje Flair.

Efterhånden som NLP-teknologien fortsætter med at udvikle sig i et bemærkelsesværdigt tempo, vil det at holde sig informeret om disse bibliotekers funktioner og udviklingstendenser hjælpe dig med at træffe det bedste valg til dine projekter og holde dine applikationer på forkant.

Hvad er dit næste NLP-projekt, og hvilket af disse biblioteker kan være det perfekte match til dine specifikke behov?